Paul Pfundt

Politik, Medien, ihnen genehme (oft fachfremde) „Experten“ vermelden permanent neue Temperaturrekorde. Die meist auf wenige Zehntel oder Hundertstel Grad genauen Daten und Temperaturveränderungen vermitteln den Eindruck von Exaktheit und wissenschaftlicher Objektivität und sollen die fortschreitende Klimakatastrophe belegen. Wir wollen hier die Frage beleuchten, wie Temperaturdaten entstehen und wie sie benutzt werden.

Globale Erwärmung und globale Durchschnittstemperatur

Die globale Erwärmung wird an gemittelten Einzelmessdaten festgemacht. Das kann statistisch korrekt sein. Doch physikalisch ist es gar nicht möglich, eine globale Durchschnittstemperatur exakt zu ermitteln. Der Physiker Prof. Peter Puschner erklärt das in einem Chatbeitrag so:

„Es werden die momentanen Temperaturwerte einer bestimmten Anzahl über die Welt verteilter Temperaturmesser gemittelt. Angenommen, die Messgeräte sind in Ordnung und es wird nicht ideologisch begründet gepfuscht, dann erhält man mit einfacher Mathematik die sog. Global-Temperatur. Temperatur beschreibt den kinetischen Zustand bewegter Teilchen, also Geschwindigkeiten. Jetzt gehen wir an eine Rennstrecke, und stellen entlang der Strecke zwischen Start und Ziel 100 Geschwindigkeitssensoren auf, also am Anfang einer Geraden, in der Mitte, am Ende vor einer Kurve, in der Kurve, nach der Kurve, eben, bis wir alle Messgeräte untergebracht haben. Und jetzt schicken wir den Rennwagen auf die Runde und erhalten die 100 Messwerte, die wir dann mitteln. Ist das jetzt die mittlere Geschwindigkeit? Zum Vergleich messen wir die Länge der gefahrenen Strecke und die Zeit von Start bis Ziel, dann sind sich bestimmt alle einig, dass aus dem Quotienten Strecke/Zeit die so ermittelte mittlere Geschwindigkeit richtig ist. Es lohnt sich dann, diese mit derjenigen zu vergleichen, die punktuell mit 100 Sensoren ermittelt wurde. Wer glaubt, da kommt derselbe Wert oder einer mit nur geringer Abweichung heraus, der sollte das Experiment wirklich einmal machen. Danach will er von Global-Temperaturen nichts mehr hören!“

Methodik

Die heute übliche Methode, Daten – genauer: deren „Verarbeitung“ in Klimamodellen – zum wesentlichen Bezugspunkt der Klimaforschung und der Klimapropaganda zu machen, folgt einer im Grunde unwissenschaftlichen Methode. Früher waren es empirische geologische Befunde (Sedimentablagerungen, Eisbohrkerne u.a.) und der historische Vergleich von Klimaentwicklungen, an denen man sich orientierte. Diese empirische Methode wurde ab etwa den 1980ern im Zuge der aufkommenden Klimakatastrophen-Ideologie durch eine mathematisch-modellhafte abgelöst. Die Stars der Klimaforschung waren nun die Modellierer, deren spekulative Prognosen die Begründung für die Klimaschutz- und CO2-Einsparpolitik abgaben.

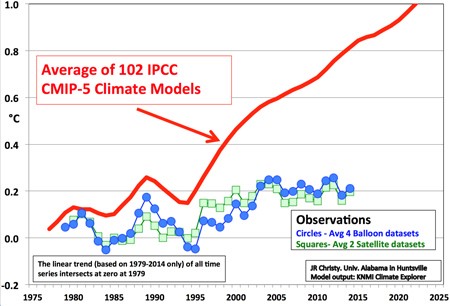

Die folgende Grafik 1 zeigt, dass die Voraussagen der Modelle sich aber immer mehr von der Realität entfernen:

Abb. 1: Modellprognosen vs. Realität

Waren früher Vergleiche langer historischer Perioden des Klimas von Tausenden oder Millionen Jahren maßgebend, bestimmt heute die Betrachtung nur eines Jahrhunderts oder weniger Jahrzehnte das Bild. Oft geht man bis 1850, dem Beginn der Industrialisierung (und des industriellen CO2-Ausstoßes), zurück oder betrachtet noch kürzere Perioden. So erscheinen Schwankungen der Temperaturen als außergewöhnlich.

Damit einher geht die These, dass die seit ca. 170 Jahren erfolgte Erwärmung von etwa 1,1 Grad ein singuläres Ereignis wäre. Doch ein Blick auf die Klimageschichte zeigt, dass diese Behauptung falsch ist. Nicht nur lange zurückliegende Klimaepochen zeigen Temperatursituationen, die sogar um mehrere Grad über oder unter dem heutigen Niveau lagen. Selbst unsere aktuelle Klimaperiode, das Holozän, das vor etwa 10.500 Jahren der letzten Eiszeit folgte, zeigt ein anderes Bild.

Wie war das Erdklima früher?

Es gab sehr lange Phasen, in denen es 5-10° wärmer war als heute. Vor etwa einer Mill. Jahre begann dann die Eiszeitära, das Pleistozän, als es ca. 5° kälter war als heute. Seit etwa 10-11.000 Jahren, im Holozän, ist das Klima etwa so wie heute. Doch das Holozän ist nur eine Warmphase innerhalb der Eiszeitepoche, ein Interglazial. D.h. in den letzten Jahrhunderttausenden war die Eiszeit das typische Klima, das nur von kurzen Warmperioden wie der heutigen, die nur etwa 10% dieser Zeit ausmachen, unterbrochen war.

Die Erwärmung von ca. 1,1° in den letzten 170 Jahren ist also vor dem Hintergrund der Klimageschichte marginal – was jedoch nicht bedeutet, dass sie uns künftig keine Probleme bereiten könnte, denn sie muss in Relation zum gegenwärtigen Zustand des Lebens und der menschlichen Gesellschaft betrachtet werden. Veränderungen von mehr als 2-3 Grad können dramatische, kaum kalkulierbare Wirkungen haben, obwohl sie erdgeschichtlich gesehen „klein“ sind. Um dazu Genaueres aussagen zu können, ist die Betrachtung des des Holozäns in Abb. 2 sinnvoll.

Abb. 2: Temperaturen im Holozän

Die Grafik zeigt, dass 1. die Temperatur im Holozän wie eine Sinuskurve mit einer Amplitude von bis zu zwei Grad geschwankt hat. 2. sehen wir, dass es meist wärmer war als heute. 3. können wir innerhalb des Holozäns einen Abkühlungstrend beobachten: die Warmphasen werden niedriger und kürzer, die Senken tiefer und häufiger. Daraus könnten wir folgern, dass die holozäne Warmphase langsam zu Ende geht. Es gab ja schon in den 1970ern Warnungen vor einer neuen Eiszeit. Da die Interglaziale bisher meist 10-12.000 Jahre dauerten, geht das Holozän rein statistisch betrachtet zu Ende. Doch ob das der tatsächlich Fall ist, wann und in welchem Maße, wissen wir nicht.

Bemerkenswert ist, dass die „Mitteltemperatur“ des Holozäns (die Mittellinie in der Grafik) bei ca. 15° Celsius liegt. Da wir uns aktuell in einer Warmphase befinden, müssten die Temperaturen im Schnitt heute also über 15° Celsius liegen. Die in den Medien verkündeten Rekordmitteltemperaturen z.B. von 2015/16 und späterer Jahre lagen aber nur bei etwa 14,8-14,9° – also noch unter dem holozänen Mittel. Im Internet finden wir zur Frage, wie hoch die Normaltemperatur der Erde ist, folgende Aussage: „Zurzeit liegt die Durchschnittstemperatur der Erde bei ungefähr 15°C. Im Vergleich zur erdgeschichtlichen „Normaltemperatur“ von 20 bis 25 °C ist das deutlich kühler, aber in der Vergangenheit lebten auch keine Menschen während der „Normaltemperatur“. Diese Aussage ist verräterisch, denn die aktuelle Temperatur ist nicht höher als der frühere „Durchschnitt“ des Holozäns. Ob es früher schon Menschen gab, spielt dabei keine Rolle – entweder es ist wärmer oder nicht.

Allein diese Fakten zeigen schon, dass wir wenig Vertrauen in die Klimamodelle, Rekordmeldungen usw. haben sollten. Bezeichnend ist in diesem Zusammenhang auch, dass der „Weltklimarat“ IPCC vor einigen Jahren den 15°-Wert für die „normale“ durchschnittliche holozäne Mitteltemperatur auf 14° geändert hat – ohne Begründung. Nur so kann aber eine signifikante Erwärmung festgestellt werden.

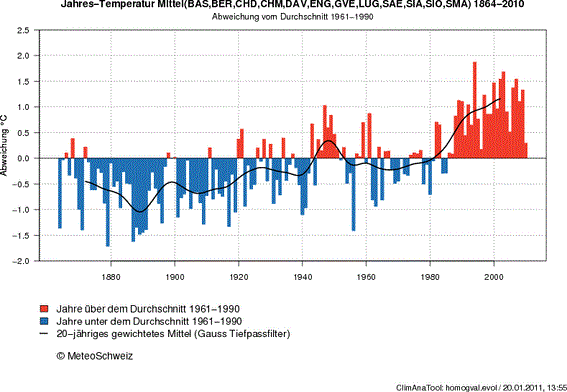

Wir wollen uns nun die Temperaturentwicklung seit etwa 1850, dem Beginn der Industrialisierung, in Abb. 3 genauer ansehen.

Abb. 3: Die Temperaturentwicklung seit 1860

Der Temperaturanstieg erfolgte nicht linear – anders als der lineare Anstieg beim CO2. Es gab Phasen der Erwärmung (1910 bis Mitte der 40er und Ende der 1970er bis 1998), Phasen der Abkühlung (1850-90) und ab Mitte der 1940er bis Ende der 1970er). Fast die gesamte Erwärmung seit 1850 erfolgte in den 1980/90er Jahren. Allerdings war das Temperaturniveau Mitte/Ende des 19. Jahrhunderts, als die „Kleine Eiszeit“ ausklang, für die Phase des Holozäns besonders niedrig. Eine Wiedererwärmung war also normal. In vielen Darstellungen der jüngsten Erwärmungsphase wird dieses niedrige Startniveau verschwiegen, um eine außergewöhnliche Klimaveränderung zu suggerieren. Innerhalb des Holozäns aber ist weder das gegenwärtige Temperaturlevel noch das Anstiegstempo in irgendeiner Hinsicht anormal. Es gab auch früher ähnliche Anstiege und Abschwünge – alle ohne Einfluss des Menschen und ohne Einfluss des CO2 .

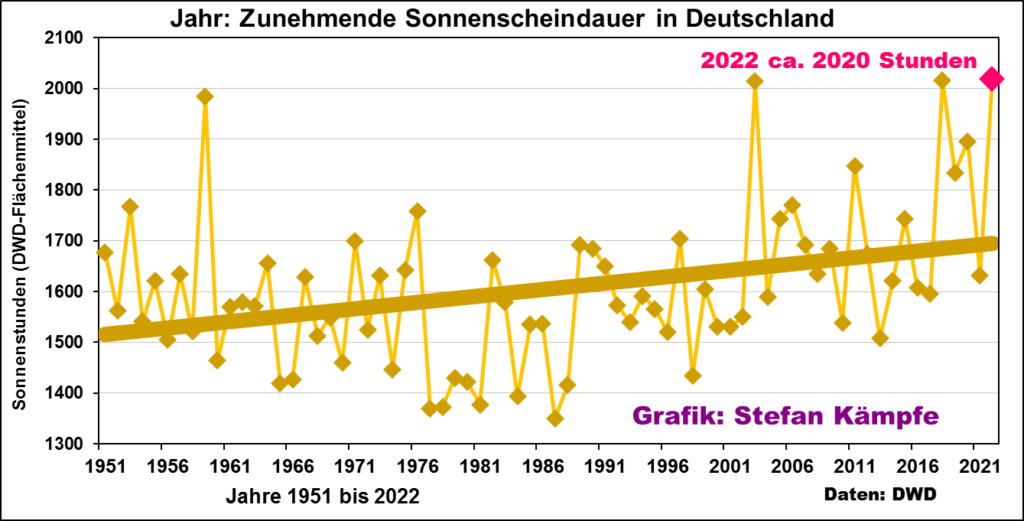

Die Erwärmungs- und Abkühlungsphasen seit 1850 belegen auf jeden Fall zwei Dinge: 1. kann CO2 kein so starker oder gar alleiniger Klimatreiber sein, denn dann sind solche, Jahrzehnte langen gegenläufigen Trends bei kontinuierlich steigendem CO2-Level unlogisch. 2. wäre selbst dann, wenn das CO2 einen signifikanten Einfluss hätte, davon auszugehen, dass es noch andere, natürliche (!) Faktoren geben muss, die auf die Temperatur einwirken. Gerade das aber ignorieren die Klimamodelle. Faktoren wie die Schwankungen der Sonnenaktivität, die langzyklischen Meeresströmungen (AMO, PDO u.a.) oder die Bewölkung (und damit die Sonnenscheindauer) tauchen darin nicht auf oder werden in ihrer Wirksamkeit radikal nach unten gestuft, so dass nur noch das CO2 als Faktor übrigbleibt. Der eigentlich simple Zusammenhang zwischen Erwärmung und mehr Sonnenstunden (klarer Himmel) wird anhand der Daten der längsten Messreihe der Sonnenscheindauer in Deutschland an der Säkularstation Potsdam KL10379 deutlich. Hier die Veränderung der Zahl der Sonnenstunden:

1895: 1039

1959: 1069

2003: 1070

2011: 1122

2018: 1147

2022: 1104.

Im März 2025 gab es in Deutschland 199 Sonnenstunden. Das entspricht statistisch etwa den Sommermonaten. Der März-Spitzenreiter war bisher 2022 mit 235 Sonnenstunden. Das Soll für März von 111 Stunden (Periode 1961 bis 1990) wurde 2025 um mehr als 75% überschritten. Selbst im Vergleich zur Periode 1991 bis 2020 (127 Stunden) zeigt sich immer noch ein Überschuss von über 50%. Diese Zunahme der Sonnenstunden erklärt zum großen Teil die Erwärmung.

Für Deutschland insgesamt zeigt sich folgendes Bild:

Abb. 4: Sonnenstunden (klarer Himmel) in Deutschland

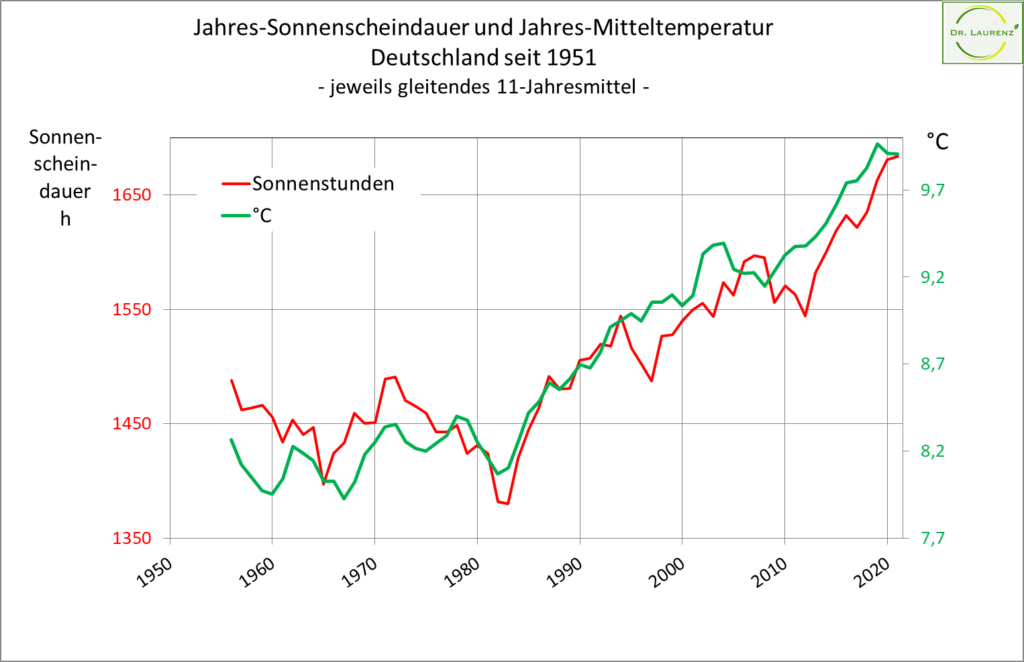

Den direkten Zusammenhang zwischen Sonnenscheindauer und Temperatur zeigt die folgende Abbildung:

Abb. 5: Sonnenscheindauer und Mitteltemperaturen

Wir sehen, dass wir die Temperaturveränderungen gut erklären können, ohne auf einen CO2-Faktor angewiesen zu sein. Die Vorgehensweise der Alarmisten, alles aus dem CO2 abzuleiten – ein methodischer „Monokausalismus“ – ist dem komplexen und tw. zyklischen, tw. chaotischen System Klimasystem völlig unangemessen und missachtet wichtige natürliche Faktoren.

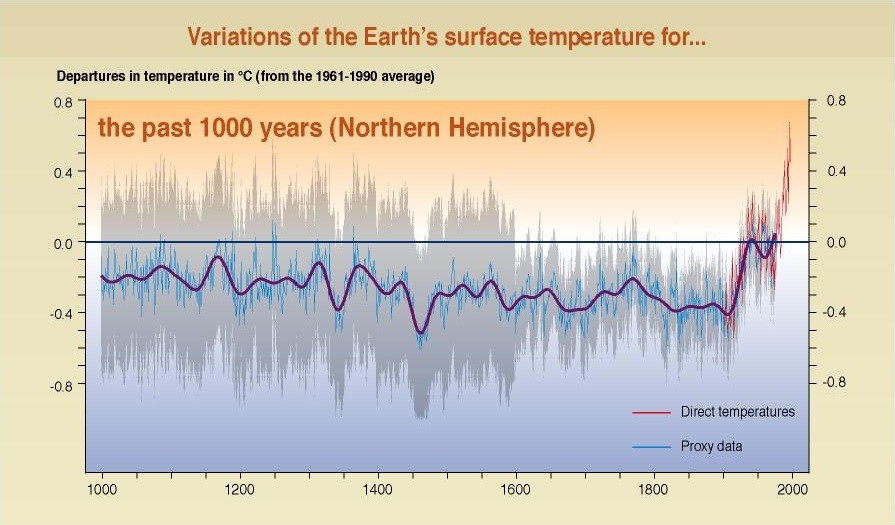

Ein bekanntes Beispiel für manipulative Darstellungen der Temperaturentwicklung ist die „Hockeystick“ (Hockeyschläger)-Kurve von Michael Mann (she. Abb. 6), um die es eine heftige Kontroverse gab. Wie bei einem Hockeyschläger folgt einer langen Plateauphase ein starker Anstieg. Die „Mittelalterliche Warmzeit“ (MAW), die letzte Warmphase des Holozäns vor unserer heutigen, verschwindet hier praktisch. Dass die MAW aber mindestens so warm war wie heute und ein globales und nicht nur ein regionale Phänomen war, belegen hunderte Studien (she. dazu hier: https://archiv.klimanachrichten.de/die-mittelalterliche-warmeperiode/). Es wurde zudem nachgewiesen, dass Manns Methode und Datengrundlage unseriös sind, weil bestimmte empirische Belege überbetont und andere ignoriert wurden. Trotzdem dauerte es Jahre, bis das IPCC die berechtigte Kritik an der Hockeystick-Kurve anerkannte und diese schließlich zurückzog.

Abb. 6: Die Hockeystick-Kurve von Michael Mann

Diese Episode ist durchaus typisch für das Lager der Alarmisten: Kritik und alternative Positionen, welche die „offizielle“ Position der anthropogenen Klimakatastrophe bezweifeln, werden meist ignoriert, während jedes „extreme“ Wetterereignis als Menetekel des Untergangs dargestellt wird.

Die Abstrusität des heutigen Klimaalarmismus kommt auch im Begriff des „vorindustriellen Klimas“ zum Ausdruck. Welches soll das sein? Das vor 500 Jahren oder das vor 5.000?! Die wärmste oder die kälteste Phase des Holozäns, die um etwa zwei Grad differieren?! Genauso unsinnig ist das 1,5-Grad-Ziel. Was ist der Bezugspunkt?! Hier entartet die Klimawissenschaft zum reinen Nonsens. Es ist kein Zufall, dass die aktuellen Globaltemperaturen meist nicht in absoluten Werten angegeben werden, sondern in der Abweichung von irgendwelchen Normal- oder vorindustriellen Werten.

Phantasievolle Daten“verarbeitung“

Prof. Puschner weist in seinem Beitrag (she. Zitat oben) auch auf das Problem der Verwendung von Daten hin. Viele Klimaforscher haben weltweit immer wieder festgestellt, dass bei der Verarbeitung der Temperaturdaten manipuliert wird. Das erfolgt auf verschiedene Weise: etwa dadurch, dass nur Daten bestimmter Stationen berücksichtigt werden – oft jene, die wärmer sind als andere. Oder es werden Daten der Vergangenheit nach unten korrigiert, um den Temperaturanstieg steiler erscheinen zu lassen usw. usw.

Ein Beispiel: Sydneys Hauptwetterstation am Observatory Hill stand kürzlich kurz davor, ein gesamtes Jahr lang unter 32 °C zu bleiben – zum ersten Mal seit Beginn der Aufzeichnungen vor über 160 Jahren. Doch dann „erschien“ plötzlich ein Solarpaneel, das direkt auf die Wetterstation gerichtet war. Das führte dazu, dass die Station diesen historischen Richtwert nicht erreichen konnte, sondern wieder eine Erwärmung zeigte. Nachdem das Ziel der Datenmanipulation erreicht war, verschwand das Paneel auf mysteriöse Weise.

Ein anderes Beispiel: In Wetterberichten werden Temperaturvoraussagen oft um mehrere Grad zu hoch angesetzt, was den Eindruck ständiger Hitzewellen hervorruft.

Die Trickserei geht tw. so weit, dass wie in Großbritannien Werte von vielen Dutzenden Wetterstationen in die Statistik eingehen, die es real gar nicht (mehr) gibt.

Ein aktuelles Beispiel: Der Bürgerjournalist Tim Reality deckte auf, wie der DWD gezielt historische Wetterdaten verschweigt, die belegen, dass es in der Vergangenheit wärmer war als angegeben. Wie macht man das? Für Dresden gibt man die Jahresmitteltemperatur erst ab 1828 an. 2024 erklärt man dann zum „Hitze-Rekordjahr“ mit einer Mitteltemperatur von 11,7 Grad Celsius. Aber 1817 lag die Mitteltemperatur bei 11,6 Grad Celsius. Da die Zählung aber erst ab 1828 beginnt, wird dieser Wert verschwiegen. In Dresden war es also vor mehr als 200 Jahren so warm wie heute.

Wohlgemerkt: es geht nicht darum, die an sich Erwärmung zu leugnen, sondern darum, wie stark sie tatsächlich ist.

Das Problem des Messens

Es gibt verschiedene Methoden, Temperaturen zu messen: mit Satelliten und Wetterballons, mit Thermometern in Wetterstationen oder mit indirekten Methoden, die Proxydaten ergeben. Dazu zählen etwa die Auswertung von Baumringen, Eisbohrkernen, Tropfsteinen oder Sedimenten. So kann man etwa aus dem Vorkommen bestimmter chemischer Stoffe oder Bakterien auf (ungefähre) frühere Temperatursituationen schließen. Wenn z.B. durch die Gletscherschmelze immer wieder Fossilien (Bäume) freigelegt werden, dann verweist das darauf, dass es früher in höheren Lagen Baumbewuchs gab, der nur bei Eisfreiheit und höheren Temperaturen möglich war. Solche Funde zeigen, dass die These von der aktuellen Gletscherschmelze z.B. in den Alpen als einem einzigartigen (!) Phänomen nicht stimmt.

Die Temperaturdaten von Wetterstationen hängen von vielen Umständen ab, welche die Messwerte beeinflussen. Dazu gehört z.B. der Standort. Steht die Station in einer „Wärmeinsel“ (Stadt, Flugplatz usw.), ist es dort wärmer als im ländlichen Umland. Ist sie für Wind offen oder steht sie windgeschützt? Steht sie im Schatten? In welcher Region steht sie? Früher zählten z.B. zu den deutschen Wetterstationen Messstellen in den ehemaligen deutschen Ostgebieten, die stärker vom Kontinentalklima beeinflusst sind. Auch die Höhenlage der Wetterstation ist wichtig, denn je höher sie steht, desto kälter ist es. Auch die Messtechnik spielt eine Rolle. Die Einführung elektronischer Messtechnik in den 1990ern etwa führte dazu, dass die Messwerte etwa ein Zehntel Grad höher wurden. Es gibt zwar international klare Regeln für Wetterstationen (Wetterhütten), doch werden diese oft nicht eingehalten, so dass die Daten verfälscht werden. So ergab eine Studie, dass 96% der 8.700 Mess-Stationen des Cooperative Observer Program (COOP) des Nationalen Wetterdienstes (NWS) der USA nicht den Standards der staatlichen Wetter- und Ozeanographiebehörde entsprechen.

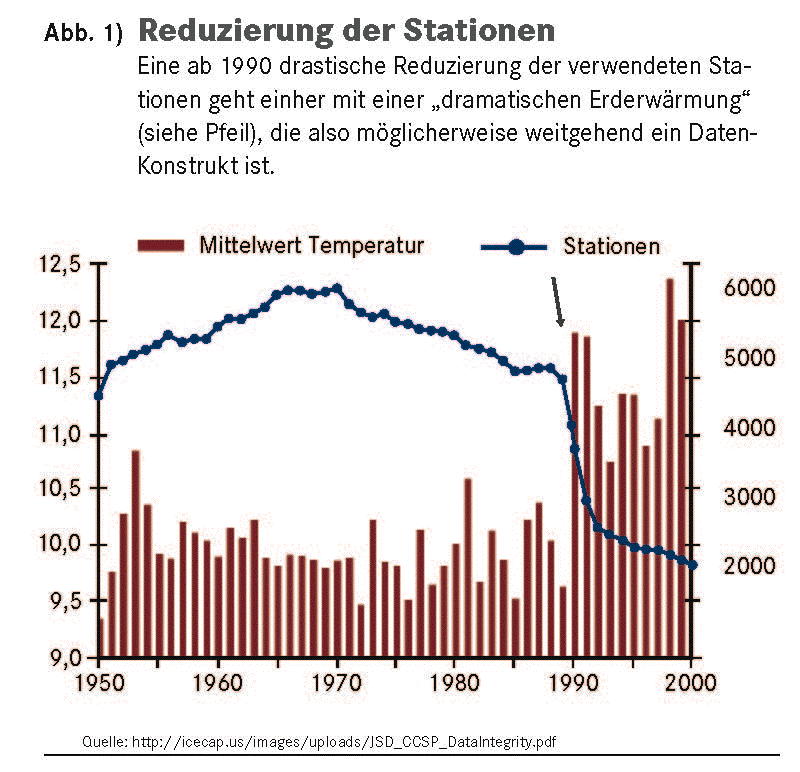

Das Netz der Wetterstationen verändert sich zudem. Stationen, die vor Jahrzehnten noch am Stadtrand lagen, befinden sich durch die Ausbreitung der Städte nun im (wärmeren) Innenstadtbereich. Alte Stationen verschwinden, neue kommen dazu. Es werden auch nur bestimmte Stationen für den Durchschnitt berücksichtigt. Grafik 7 zeigt den Zusammenhang zwischen der Zahl der weltweiten Stationen, die berücksichtigt werden, und einem Sprung bei den Temperaturdaten:

Abb. 7: Temperaturmessstationen weltweit und Temperaturdaten

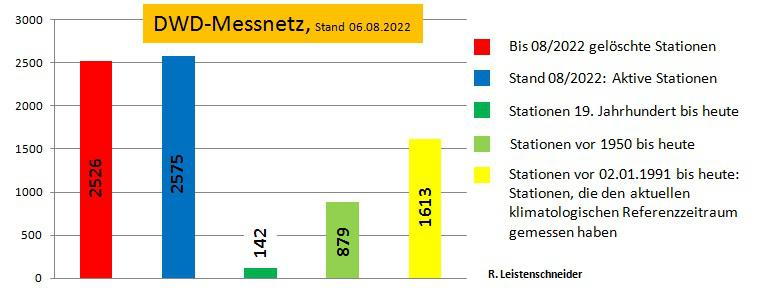

Auch der Mix der Messtationen in Deutschland hat sich stark verändert (she. Grafik 8). Den größten Teil stellen Stationen neueren Datums, was Vergleiche der Temperaturen verschiedener Zeiten sehr erschwert. In den letzten 140 Jahren hat der Deutsche Wetterdienst (DWD) sein Stationsnetz vollkommen ausgetauscht. Nur noch etwa 1% der heutigen Stationen haben auch schon 1881 gemessen. Jedoch standen diese Stationen meist an viel kälteren Standorten als heute.

Abb. 8: Alter der DWD-Messstationen

Zu diesem Trauerspiel beim Umgang mit den Temperaturdaten gesellt sich das Problem der Landdaten für den Zeitraum von 1850-1900. Diese stammen zu gut 90% nur aus den USA und Kanada und kommen erfassen fast alle erst den Zeitraum ab 1890. Mit solchen Daten kann man wenig anfangen und schon gar keine historischen und globalen Trends darstellen. Die fehlenden Realdaten werden dann in den Modellen oft extrapoliert. Mit Wissenschaft hat das wenig zu tun (vgl. dazu: https://eike-klima-energie.eu/2023/12/15/knapp-70-ausfall-vorindustrielle-temperaturdaten-sind-mehr-oder-weniger-frei-erfunden/).

Natürliche Klimafaktoren

Die Hauptfaktoren, die das Klima und die Temperatur bestimmen, sind natürliche, vom Menschen unabhängige, die nichts mit dem CO2 zu tun haben. Dazu zählen v.a. die Schwankungen der Sonne. Die Alarmisten verweisen zwar zu recht darauf, dass die Schwankungen des sichtbaren Lichts so gering sind (unter 1%), dass sich die Temperaturschwankungen nicht daraus erklären lassen. Sie ignorieren allerdings, dass andere Schwankungen der Sonnenaktivität, z.B. des Magnetfeldes oder der nicht sichtbaren Strahlung, weit größer sind. Diese Zusammenhänge sind jedoch noch zu wenig erforscht. Einen Fortschritt in dieser Hinsicht stellt evtl. der von Prof. Hendrik Svensmark entdeckte und nach ihm benannte Effekt dar. Er besagt, dass eine aktivere Sonne durch ein stärkeres Magnetfeld die interstellaren Partikelströme ablenkt. Diese Partikel wirken als Kristallisationskeime für Wolken. Eine aktivere Sonne vermindert also die Bewölkung, was mehr Sonnenstunden, also Zusatzerwärmung bedeutet: eine positive Rückkopplung.

Wesentlich für das Erdklima sind auch die Mylankovic-Zyklen, die die Änderungen der Erdbahn und der Positionierung der Erde zur Sonne beschreiben sowie die Schwankungen (das „Taumeln“) der Sonne auf ihrer Bahn.

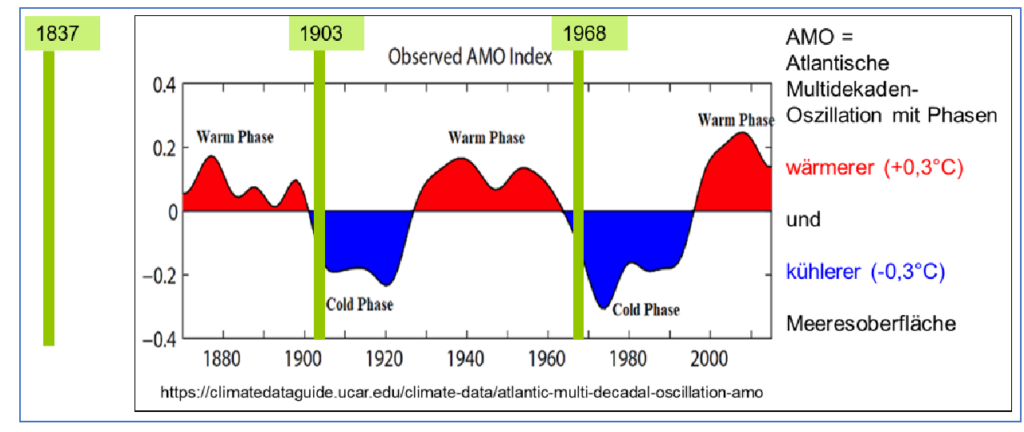

Erst in den letzten Jahrzehnten wurde die bedeutende Rolle der Meeresströmungen und ihrer Zyklik verstanden. Zyklen von 60-80 Jahren in Pazifik (PDO) und Atlantik (AMO) transportieren gewaltige Mengen kalten oder warmen Wassers und bestimmen so wesentlich die Temperaturen in Amerika und Europa. Je nachdem, welche Phase gerade überwiegt, verhalten sich die Temperaturen. Ganz im Unterschied zur Behauptung, dass CO2 die Temperatur wesentlich bestimmt, gibt es eine weit bessere Übereinstimmung der Temperatur mit der Zyklik der Sonne und der Meere. Die folgende Grafik 9 zeigt die gute Übereinstimmung von AMO und Temperaturen in Europa:

Abb. 9: AMO und Temperaturentwicklung

Diese Zusammenhänge zwischen Temperaturen und natürlichen Faktoren sowie die Probleme beim Messen werden von der IPCC-nahen „Wissenschaft“, von Politik und Medien weitgehend ignoriert.

Einfluss des Menschen

Dass natürliche Faktoren entscheidend für die Temperatursituation sind, bedeutet nicht, dass der Mensch keinen Einfluss hätte. Tatsächlich bewirken fast alle Maßnahmen des Menschen – genauer: der kapitalistischen Produktionsweise – eine Erwärmung. Dazu zählen u.a.:

- die Verbrennung fossiler Stoffe und die damit verbundene Freisetzung von Energie, die vorher in der Erdkruste gebunden war (Kohle, Gas, Öl);

- die Jahrhunderte lange Entwaldung, die zur Aufheizung der Erdoberfläche führt;

- die Trockenlegung von Feuchtflächen (Tümpel, Bäche, Moore, Auen) und die Entwässerung von Feldern, Wiesen und Wäldern;

- die Urbanisierung von Naturflächen.

Gerade der letztere Faktor wirkt sich immer stärker aus, weil durch die wachsende Menschheit und die Ausbreitung von Städten, Straßen und Gewerbezonen immer mehr Naturflächen umgewandelt werden. Der Flächenfraß in Deutschland beträgt derzeit 58 Hektar pro Tag. Der größte Teil, nämlich 40 Hektar, geht dabei auf das Konto des Wohnungsbaus sowie der Schaffung von Industrie- und Gewerbeflächen. Von 1992-2021 hat die urbane Fläche in Deutschland von 40.305 auf 51.813 Quadratkilometer zugenommen.

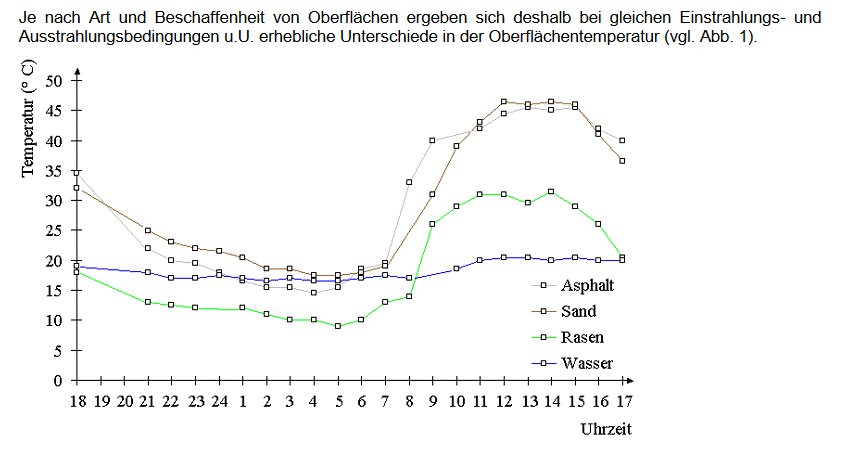

Das hat eine doppelte Wirkung: 1. steigt die Temperatur in urbanen Zentren gegenüber der in freier Landfläche (Wiesen, Wälder usw.) an. Das hat u.a. damit zu tun, dass es in Städten weniger beschattete Fläche gibt als etwa in einem Wald. In Städten entstehen mehr Emissionen (Heizung, Autoabgase), die die Luft aufheizen. Die Stoffe, aus denen Städte bestehen (Beton, Stein, Asphalt usw.) absorbieren Strahlung besser, heizen sich also stärker auf. Wie warm z.B. Asphalt in der Sonne wird, weiß jeder aus Erfahrung. Genauso kennen wir den kühlenden Effekt, den etwa Parks oder baumbestandene Friedhöfe haben. Eine Rolle spielt auch, dass die Oberfläche von Städten durch mehrgeschossige Gebäude größer ist und daher mehr Wärme gespeichert wird. Diese Effekte werden mit dem Begriff „Wärmeinseleffekt“ (WIE) erfasst. Der Temperaturunterschied zwischen der Stadt und der ländlichen Umgebung kann 1-5 Grad betragen. Ist eine Stadt an einem heißen Sommerabend aufgeheizt, kann die Differenz zur Temperatur des Umlands noch weit höher ausfallen. Die immer weiter zunehmende Urbanisierung ist also ein wichtiger Temperaturtreiber. Grafik 10 zeigt das unterschiedliche Wärmeverhalten verschiedener Stoffe.

Abb. 10: Das Temperaturverhalten verschiedener Stoffe

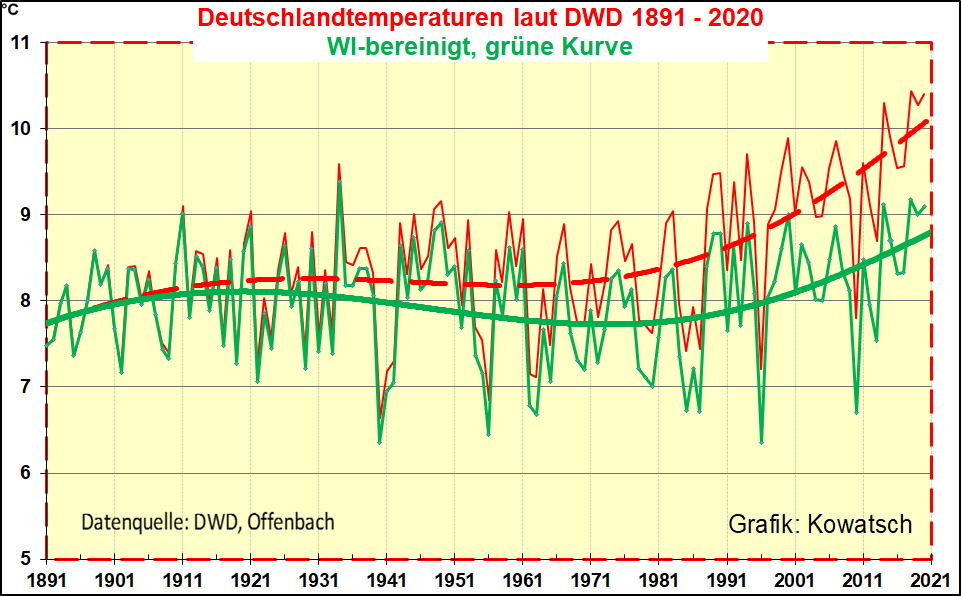

Ein zweiter Effekt der Urbanisierung besteht darin, dass viele Wetter- und Messstationen in Städten stehen und damit die dort höheren Temperaturen messen. Je mehr städtische Stationsdaten in die Durchschnittswerte eingehen, desto höher werden diese. Weltweit ist zu beobachten, dass der Anteil von urbanen Stationen steigt. Diese, durch den WIE bedingte, „statistische Erwärmung“ wird von den alarmistischen Medien und auch den Wetterorganisationen kaum berücksichtigt, was nichts anderes ist Manipulation. Grafik 11 zeigt den Unterschied der Temperaturdaten mit und ohne den WIE:

Abb. 11: Deutschland-Temperaturen mit und ohne WIE

Wir sehen hier, dass es in den letzten Jahrzehnten zwar eine reale Erwärmung gab, diese jedoch um einige Zehntel niedriger ist, als es die Alarmisten darstellen.

Das Jonglieren mit Temperaturdaten, wie es uns die Medien täglich vorführen, ist weitgehend ein absurdes Theater, mit dem weder das wirkliche Ausmaß der Erwärmung noch deren Ursachen dargestellt werden können. Es handelt sich hier nicht um Information, sondern um Alarmismus, der als ideelle Begründung für die Profit- und Herrschaftsinteressen bestimmter Kapitalgruppen (Energiewendepolitik) und deren politisch-staatlichen Marionetten dient. Dass das Gros der Linken dieses Klima-Katastrophen-Theater nicht durchschaut, sondern es noch links überholen will, zeigt nur, wie schlecht es um deren Analyse- und Kritikfähigkeit bestellt ist.